机器之心&ArXiv Weekly Radiostation

参与:杜伟,楚航,罗若天

本周的重要论文有阿里达摩院在自动驾驶领域的新成果,以及复旦大学邱锡鹏教授发表的预训练模型综述论文。

目录:

MIP = RE

Rapid online learning and robust recall in a neuromorphic olfactory circuit

Disrupting Deepfakes: Adversarial Attacks Against Conditional Image Translation Networks and Facial Manipulation Systems

ReZero is All You Need: Fast Convergence at Large Depth

Structure Aware Single-Stage 3D Object Detection from Point Cloud

Pre-trained Models for Natural Language Processing: A Survey

AutoGluon-Tabular: Robust and Accurate AutoML for Structured Data

ArXiv Weekly Radiostation:NLP、CV、ML更多精选论文(附音频)

论文 1:MIP = RE

作者:Zhengfeng Ji、Anand Natarajan、Henry Yuen 等

论文链接:https://arxiv.org/pdf/2001.04383.pdf

摘要:这篇长达 165 页的论文所揭示的研究成果,一经发布,就在学界引发了广泛的关注,《Nature》杂志也对此进行了介绍。在该论文中,五位计算机科学家为可通过计算方式验证的知识确立了一个新的边界。基于此,他们又为量子物理学和纯数学领域仍未得到解决的重大难题带去了答案。这个新证明就是:在理论上,使用纠缠态量子比特(qubit)而非经典的 1 和 0 进行计算的量子计算机可用于验证非常多的问题的答案。

该证明的作者有多伦多大学的 Henry Yuen、悉尼科技大学的季铮锋(Zhengfeng Ji)、加州理工学院的 Anand Natarajan 和 Thomas Vidick 以及德克萨斯州大学奥斯汀分校的 John Wright。这五位研究者都是计算机科学家。

本文作者、计算机科学家 Henry Yuen、Thomas Vidick、Zhengfeng Ji、Anand Natarajan 和 John Wright 合作证明了一个验证计算问题的答案的问题,却最终为数学和量子物理学领域的重大问题提供了解答。

图片来自:Lucy Reading-Ikkanda/Quanta Magazine

推荐:针对这篇「不明觉厉」的 165 页长篇论文,有网友表示「现在要取得科学上的新突破,把物理与数学紧密结合形成团队进行深入研究是非常有效的一种方式。像以前仅仅靠单打独斗的方式或者只考虑自己本学科的研究体系已经不适应当今科学发展的需要。交叉学科的有机融合将会带来科学大发展的新一轮机遇。」

论文 2:Rapid online learning and robust recall in a neuromorphic olfactory circuit

摘要:近日,来自英特尔和康奈尔大学的研究者宣布,团队已经在神经形态芯片 Loihi 上成功设计了基于大脑嗅觉电路的算法,实现了在线学习和强记忆力能力。这项研究发表在最新一期自然杂志子刊上《Nature Machine Intelligence》上,并成为封面文章。

在该研究中,研究者展示了英特尔神经形态研究芯片 Loihi 在存在明显噪声和遮盖的情况下学习和识别危险化学品的能力。该系统基于英特尔的神经形态研究芯片 Loihi 和 72 个化学传感器,Loihi 被编程为模仿嗅球中神经元的运作——后者是区分不同气味的大脑区域。研究人员表示,这一系统未来可被用于监视空气中的有害于人体健康的物质,嗅出隐藏的毒品或爆炸物,或帮助进行医学诊断。

论文第一作者,英特尔实验室的 Nabil Imam 和 Loihi 测试版神经芯片。该团队正在芯片上构建算法模仿人类闻到某种气味后大脑神经网络中发生的情况。

模型架构和信号编码。

推荐:因为效率颇高,Pohoiki Beach 和 Loihi 有望成为人工智能算法发展的新动力。英特尔称,新形态的芯片可以在图像识别、无人驾驶和自动化机器人等方面带来巨大技术提升。

论文 3:Disrupting Deepfakes: Adversarial Attacks Against Conditional Image Translation Networks and Facial Manipulation Systems

作者:Nataniel Ruiz、Sarah Adel Bargal、Stan Sclarof

论文链接:https://arxiv.org/abs/2003.01279

摘要:对抗攻击,常见于欺骗各种图像识别模型,虽然也能用于图像生成模型,但似乎意义不是那么大。不过如果能用在 deepfake 这类换脸模型,那就非常有前景了。在这篇论文中,研究者正是沿着对抗攻击这条路「欺骗」deepfake 的换脸操作。

具体而言,研究者首先提出并成功应用了:可以泛化至不同类别的可迁移对抗攻击,这在某种程度上预示着攻击者不有必要了解图像的类别;用于生成对抗网络(GAN)的对抗性训练,这是实现鲁棒性图像转换网络的第一步;在灰盒(gray-box)场景下,使输入图像变模糊可以成功地防御攻击,研究者展示了一个能够规避这种防御的攻击方法。

干扰 deepfake 生成的流程图。使用 I-FGSM 方法,在图像上应用一组无法觉察的噪声,之后就能成功地干扰人脸操纵系统(StarGAN)的输出结果。

研究者提出这种对抗攻击的效果。

高斯模糊防御的成功示例。

推荐:这篇波士顿大学的研究放出来没多久,就受到很多研究者的热议,在 Reddit 上也有非常多的讨论。

论文 4:ReZero is All You Need: Fast Convergence at Large Depth

作者:Thomas Bachlechner、 , Bodhisattwa Prasad Majumder、Julian McAuley 等

论文链接:https://arxiv.org/pdf/2003.04887v1.pdf

摘要:在本文中,为了促进深度信号传播,来自加州大学圣迭戈分校的研究者提出了 ReZero,对于将任意层初始化为恒等映射(identity map)的架构,ReZero 做了简单的更改,并在每层使用单个学得的附加参数。他们将这种方法应用到语言建模中,结果发现能够在 100 多个层上轻松地训练 ReZero-Transformer 网络。

当应用于 12 层的 Transformers 时,ReZero 在 enwiki8 数据集上的收敛速度提升了 56%。除了 Transformer,ReZero 还能应用于其他残差网络,使得深度全连接网络的收敛速度提升 1,500%,在 CIFAR 10 数据集上训练的 ResNet-56 的收敛速度也提升了 32%。

ReZero 流程图。

不同形式的正则化和残差连接。「F」表示任意层的转换,「Norm」表示正则化(如 LayerNorm 或 BatchNorm)。

用于 Transformers 的 ReZero。

推荐:使用本文提出的ReZero,研究者能够高效地训练数百层深度的 Transformers,并相信更深度的 Transformers 将有助于未来进一步的研究探索。

论文 5:Structure Aware Single-Stage 3D Object Detection from Point Cloud

摘要:阿里巴巴达摩院在无人驾驶 3D 物体检测方面又有新成果发布。达摩院一篇名为《Structure Aware Single-Stage 3D Object Detection from Point Cloud》的论文入选 CVPR 2020。

该论文提出了一个通用、高性能的检测器,首次实现 3D 物体检测精度与速度的兼得,有效提升无人驾驶系统安全性能。该论文团队表示,「检测器是无人驾驶系统的核心组件之一,但这一领域一直以来缺少创新和突破,此次我们提出的检测器融合了单阶段检测器和两阶段检测器的优势,因此同时实现了 3D 检测精读和速度的提升,未来检测器的创新研究还能解决无人驾驶产业的更多难题。」

KITTI BEV 排行榜,达摩院位居第一。

研究者提出的方法 (黑色) 在 KITTI 数据库上的 PR Curve,其中实线为两阶段方法,虚线为单阶段方法。能够正常的看到我们作为单阶段方法能达到两阶段方法才能达到的精度。

推荐:研究结果显示,该检测器在 KITTI BEV(bird`s eye view)排行榜上排名第一, 检测速度达到 25FPS,同时精度也超过其他的单阶段检测器。

论文 6:Pre-trained Models for Natural Language Processing: A Survey

作者:Xipeng Qiu、Tianxiang Sun、Xuanjing Huang 等

论文链接:https://arxiv.org/pdf/2003.08271.pdf

摘要:我们大家都知道 BERT、ALBERT、XLNet 等众多优秀模型,但它们之间的关系、差别、分类到底是怎样的?这还是主流模型,如果没读过具体论文,我们是很难分清楚的,对于更多的变体与扩展,基本上就无能为力了。但近日复旦大学邱锡鹏等研究者发了一篇论文,它以两张图详细展示了预训练语言模型的现状与分类。复旦的这篇综述性论文非常丰富,它以 25 页的篇幅展示了预训练语言模型的方方面面,不论是新奇的预训练任务,还是各种模型针对领域知识的扩展,我们都能快速 Get 到。

具体而言,以邱锡鹏为第一作者的研究者们对用于 NLP 的预训练模型进行了全面的回顾,文章体结构如下:首先简要介绍了语言表示学习及相关研究进展;其次从四个方面对现有 PTM 进行系统分类(Contextual、Architectures、Task Types、Extensions);再次描述了如何将 PTM 的知识应用于下游任务;最后展望了未来 PTM 的一些潜在发展趋势。

NLP 任务的一般神经架构。

带有典型实例的 PTM 分类法。

具有代表性的预训练模型列表。

推荐:研究者表示,本文旨在为读者理解、使用和开发适用于不同 NLP 任务的预训练模型提供一份实用指南,这篇论文在机器学习社区上也得到了很广泛的响应。

论文 7:AutoGluon-Tabular: Robust and Accurate AutoML for Structured Data

作者:Nick Erickson、Jonas Mueller、Alexander Smola 等

论文链接:https://arxiv.org/pdf/2003.06505.pdf

摘要:在本文中,来自亚马逊的研究者提出了新的 AutoML 开源框架 AutoGluon-Tabular,它只需要几行 Python 代码就可以在 CSV 文件等未处理的纯属性数据集上训练高精度的机器学习模型。与当前侧重于模型/超参数选择的 AutoML 框架不同,通过集成多个模型并将它们堆叠在多层上,AutoGluon-Tabular 取得了成功。实现表明,本文中多个模型的多层组合能够更好地利用分配的时间。

AutoGluon-Tabular 架构示意图。

算法 1:AutoGluon-Tabular 训练策略。

推荐:文中全面的实证性评估表明,AutoGluon-Tabular 比专注于组合算法选择和超参数优化(CASH)的流行 AutoML 框架表现出更高的准确度。

ArXiv Weekly Radiostation

机器之心联合由楚航、罗若天发起的ArXiv Weekly Radiostation,在 7 Papers 的基础上,精选本周更多重要论文,包括NLP、CV、ML领域各10篇精选,并提供音频形式的论文摘要简介,详情如下:

本周 10 篇 NLP 精选论文是:

1. Stanza: A Python Natural Language Processing Toolkit for Many Human Languages. (from Peng Qi, Yuhao Zhang, Yuhui Zhang, Jason Bolton, Christopher D. Manning)

2. Recent Advances and Challenges in Task-oriented Dialog System. (from Zheng Zhang, Ryuichi Takanobu, Minlie Huang, Xiaoyan Zhu)

3. A Formal Analysis of Multimodal Referring Strategies Under Common Ground. (from Nikhil Krishnaswamy, James Pustejovsky)

4. Rethinking Batch Normalization in Transformers. (from Sheng Shen, Zhewei Yao, Amir Gholami, Michael Mahoney, Kurt Keutzer)

5. TTTTTackling WinoGrande Schemas. (from Sheng-Chieh Lin, Jheng-Hong Yang, Rodrigo Nogueira, Ming-Feng Tsai, Chuan-Ju Wang, Jimmy Li)

6. Developing a Multilingual Annotated Corpus of Misogyny and Aggression. (from Shiladitya Bhattacharya, Siddharth Singh, Ritesh Kumar, Akanksha Bansal, Akash Bhagat, Yogesh Dawer, Bornini Lahiri, Atul Kr. Ojha)

7. MixPoet: Diverse Poetry Generation via Learning Controllable Mixed Latent Space. (from Xiaoyuan Yi, Ruoyu Li, Cheng Yang, Wenhao Li, Maosong Sun)

8. Diversity, Density, and Homogeneity: Quantitative Characteristic Metrics for Text Collections. (from Yi-An Lai, Xuan Zhu, Yi Zhang, Mona Diab)

9. Word Sense Disambiguation for 158 Languages using Word Embeddings Only. (from Varvara Logacheva, Denis Teslenko, Artem Shelmanov, Steffen Remus, Dmitry Ustalov, Andrey Kutuzov, Ekaterina Artemova, Chris Biemann, Simone Paolo Ponzetto, Alexander Panchenko)

10. Utilizing Language Relatedness to improve Machine Translation: A Case Study on Languages of the Indian Subcontinent. (from Anoop Kunchukuttan, Pushpak Bhattacharyya)

本周 10 篇 CV 精选论文是:

1. Child Face Age-Progression via Deep Feature Aging. (fromDebayan Deb, Divyansh Aggarwal, Anil K. Jain)

2. Generalizing Face Representation with Unlabeled Data. (from Yichun Shi, Anil K. Jain)

3. Differential Treatment for Stuff and Things: A Simple Unsupervised Domain Adaptation Method for Semantic Segmentation. (from Zhonghao Wang, Mo Yu, Yunchao Wei, Rogerior Feris, Jinjun Xiong, Wen-mei Hwu, Thomas S. Huang, Honghui Shi)

4. Deep Affinity Net: Instance Segmentation via Affinity. (from Xingqian Xu, Mang Tik Chiu, Thomas S. Huang, Honghui Shi)

5. High-Order Information Matters: Learning Relation and Topology for Occluded Person Re-Identification. (from Guan'an Wang, Shuo Yang, Huanyu Liu, Zhicheng Wang, Yang Yang, Shuliang Wang, Gang Yu, ErjinZhou, Jian Sunn)

6. PointINS: Point-based Instance Segmentation. (from Lu Qi, Xiangyu Zhang, Yingcong Chen, Yukang Chen, Jian Sun, Jiaya Jia)

7. Frustratingly Simple Few-Shot Object Detection. (from Xin Wang, Thomas E. Huang, Trevor Darrell, Joseph E. Gonzalez, Fisher Y)

8. Personalized Taste and Cuisine Preference Modeling via Images. (from Nitish Nag, Bindu Rajanna, Ramesh Jain)

9. Semantic Pyramid for Image Generation. (from Assaf Shocher, Yossi Gandelsmam, Inbar Mosseri, Michal Yarom, Michal Irani, William T. Freeman, Tali Dekel)

10. Curriculum DeepSDF. (from Yueqi Duan, Haidong Zhu, He Wang, Li Yi, Ram Nevatia, Leonidas J. Guibas)

本周 10 篇 ML 精选论文是:

1. Post-Estimation Smoothing: A Simple baseline for Learning with Side Information. (from Esther Rolf, Michael I. Jordan, Benjamin Recht)

2. Compressing deep neural networks on FPGAs to binary and ternary precision with HLS4ML. (from Giuseppe Di Guglielmo, Javier Duarte, Philip Harris, Duc Hoang, Sergo Jindariani, Edward Kreinar, Mia Liu, Vladimir Loncar, Jennifer Ngadiuba, Kevin Pedro, Maurizio Pierini, Dylan Rankin, Sheila Sagear, Sioni Summers, Nhan Tran, Zhenbin Wu)

3. Semi-supervised Disentanglement with Independent Vector Variational Autoencoders. (from Bo-Kyeong Kim, Sungjin Park, Geonmin Kim, Soo-Young Leee)

4. Tensor Graph Convolutional Networks for Multi-relational and Robust Learning. (from Vassilis N. Ioannidis, Antonio G. Marques, Georgios B. Giannakis)

5. Toward Interpretable Machine Learning: Transparent Deep Neural Networks and Beyond. (from Wojciech Samek, Grégoire Montavon, Sebastian Lapuschkin, Christopher J. Anders, Klaus-Robert Müller)

6. Intra Order-preserving Functions for Calibration of Multi-Class Neural Networks. (from Amir Rahimi, Amirreza Shaban, Ching-An Cheng, Byron Boots, Richard Hartley)

7. Deep Multi-Agent Reinforcement Learning for Decentralized Continuous Cooperative Control. (from Christian Schroeder de Witt, Bei Peng, Pierre-Alexandre Kamienny, Philip Torr, Wendelin B hmer, Shimon Whiteson)

8. ParKCa: Causal Inference with Partially Known Causes. (from Raquel Aoki, Martin Ester)

9. Anomalous Instance Detection in Deep Learning: A Survey. (from Saikiran Bulusu, Bhavya Kailkhura, Bo Li, Pramod K. Varshney, Dawn Song)

10. Regret Bound of Adaptive Control in Linear Quadratic Gaussian (LQG) Systems. (from Sahin Lale, Kamyar Azizzadenesheli, Babak Hassibi, Anima Anandkumar)

2024华为全屋智能设计大赛·山东站正式启动

2024华为全屋智能设计大赛·山东站正式启动 钱江世纪城“桥上市集”点燃杭城炎炎夏夜

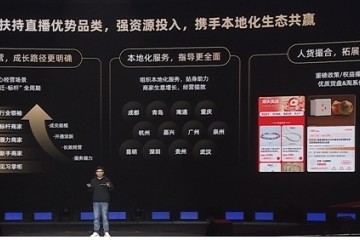

钱江世纪城“桥上市集”点燃杭城炎炎夏夜 走进产业带商家:看淘宝直播如何为商家迎来“新生”

走进产业带商家:看淘宝直播如何为商家迎来“新生” 生鲜业务如何兼顾“高质低价”?揭秘鼻祖级玩家的解题思路

生鲜业务如何兼顾“高质低价”?揭秘鼻祖级玩家的解题思路 “19岁,绝美青春”:绝味鸭脖再推新品引爆中国休闲卤制品市场

“19岁,绝美青春”:绝味鸭脖再推新品引爆中国休闲卤制品市场 淘宝直播产业带新财年服务商大会|百亿流量扶持中小商家续写“源头奇迹

淘宝直播产业带新财年服务商大会|百亿流量扶持中小商家续写“源头奇迹 绝味鸭脖×元梦之星打造数实融合新典范,新品爆一脖39天热卖100万桶

绝味鸭脖×元梦之星打造数实融合新典范,新品爆一脖39天热卖100万桶 膳魔师:以创新之光,照亮百年品牌

膳魔师:以创新之光,照亮百年品牌