中科院自动化研讨所研讨员曾毅博士以为,其时根据数据的人工智能与生物智能有着本质的差异,未来人工智能的展开方向将是“根据机制的人工智能”,也便是探寻生物智能的本质——了解人脑是怎样和谐数百项认知功用去处理没见过的问题的,根据此,完结机器的拟人化和人类认知的机械化两个方向的迫临,展开出具有知道的超级智能生命体。

文章节选自我国人民大学出版社的《人工智能全球格式:未来趋势与我国位势》一书。本书由国务院展开研讨中心世界技能经济研讨所、我国电子学会和才智芽合著,集结了人工智能范畴许多权威人士的见地。作为一本人工智能科普读物,该书得到百度CTO王海峰博士盛赞,以及倪光南、邬贺铨两位院士的一起引荐。

智能数据剖析≠实在含义的人工智能

关于媒体上盛行的工业驱动的人工智能故事,咱们都听过十分多了,我对它的总结是:其时简直全部这些作业,精确地说叫作根据数据的人工智能(data based artificial intelligence),简称数据智能。

由于,这些作业是根据大规模数据,找到一个适宜的数学函数来拟合数据,发生拟定的预期。如AlphaGo,假如反诘:经过AlphaGo一系列的作业,咱们对人类的决议计划机制有了哪些新的知道?其实是简直没有的。因而,根据数据构建的看似智能的模型,其本质仅仅信息处理,是大规模的数据剖析,与“智能”的本质无关。

可是,我信任未来的人工智能是向机制智能展开的。

咱们称之为“根据机制的人工智能”(mechanism based artificial intelligence)。也便是说,咱们实在需求寻找的是生物智能的本质。关于恣意一项认知功用,包含对人脑怎样去和谐数百项的认知功用去处理没见过的问题的探究,都是在答复它的科学本质是什么。

人工智能研讨从开端至今不过短短几十年,而实在人类的智能现现已过了数亿年的演化,在演化过程中经过基因突变等取得了不同的测验,生成了不同物种的脑。为什么数亿年的演化,把人脑塑构成这样,而不是果蝇或许小鼠的姿态?人脑又有什么样的优势?咱们做的作业是从不同类型物种的大脑的建模开端,从中笼统出认知结构与机理,然后使用到机器智能傍边去。

数亿年的演化使得人类大脑把人体体系的结构和机制有机地组合起来,使得人体体系表现出更好的鲁棒性和抗噪才能。在现在最抱负的情况下,深度学习体系在有足够多的数据练习,而且测验数据与练习数据都抱负的情况下,能够取得与人类大脑平等水平的鲁棒性和抗噪才能。可是,在任何客观的实际世界中,抱负的情况都不存在。脑结构与机制的结合使得高度鲁棒性和抗噪功用够从咱们构建的类脑模型中呈现出来,这并非特定的函数规划所能完结的。

人类显然有很强的决议计划才能。人的决议计划是经过若干脑区的协同来完结的。咱们把这样的决议计划模型放到无人机、机器人等不同渠道上,使得无人机等学会自主避障、自主穿越杂乱场景。全部的规矩都是在线学习的,机器人学习的速度刚开端跟人相似,后边则比人快,由于其核算才能比人强。把相同的模型用到机器人上,让它去了解人类的目的等不同的使用,其实都仅仅类脑人工智能在狭义人工智能中的一些展开。

现在正在探究的问题,便是怎样使得模型变得通用。

比方,谷歌DeepMind提出的模型,它期望一种网络能够应对多个使命。可问题是:当它学习第二个使命的时分,第一个使命的功用也会下降,假如它还想一起完结第一个使命的话,第二个使命也不能得到最好应对。这都不是人类智能的特色。人脑至少能够分红近250个脑区。这些脑区是自组织协同的,能够去应对不同的使命,也便是说,人脑的自组织原理才是最重要的。

人类的认知功用至少有150项,到现在为止,全世界的人工智能顶多应战了其间的30项,剩下的绝大多数很少有人去研讨,比方说知道的问题。在神经科学范畴,能够经过2~5周的练习使得以往被以为没有自我知道的恒河猴经过镜像测验,然后被以为呈现出了自我知道。在这样的试验的启发下,咱们构建了猴脑的点神经元脉冲神经网络模型,该模型具有363个脑区。使用近似猴脑的核算模型以及相关的练习试验,机器人经过了镜像测验。现在,尽管机器人能够经过镜像测验,但问题是,咱们能说机器人有了自我知道吗?

咱们能够说,山公经过了镜像测验,所以咱们以为这个物种有自我知道;但反过来,机器人经过了能够阐明吗?实际上不可。所以,现在咱们的结论是:一个不具备人类以为的知道才能的机器人,它也能经过镜像测验。因而,传统镜像测验判别物种是否具有自我知道的假定实际上是不谨慎的。完结机器的自我知道是咱们重要的尽力方向,很显然这还仅仅开端自我感知的开端。

全体而言,咱们期望未来能经过核算建模来发现智能演化的规矩,猜测智能演化的趋势,并使用到未来人工智能模型的自主智能演化上。

探究未来智能的两个方向

其时咱们在智能的探究上做了两个方向上的尽力,一个是从机器向拟人化展开,一个是从人类向机械化方向展开,扩展人类的智能。

一方面,机器的拟人化(humanization)使得机器越来越像人,使它能够与未来的人类更好地交互。另一方面,人类也在经过延展认知才能提高着本身,所以这部分作业叫作mechanization,便是机械化。未来人工智能的展开便是从上述两个方向迫临,向具有知道的超级智能生命体展开。

两个方向需求答复的科学问题起点是不相同的。从机器智能的视点动身,咱们需求答复它们究竟是谁、咱们究竟怎样构建一个具有智能的生命的问题。从人类的视点动身,问题是咱们人的大脑是怎样作业的、咱们是谁。未来,有知道的超级智能生命体的展开不是分裂的,不是两个方向无关的尽力,而是两个方向朝着共同的方针深度交融探究的未来。

我国的人工智能社会道德问题研讨亟待加强

未来的超级智能体很显然会逾越现代人类智力水平,其危险和道德问题将是十分要害的一环。

我国已采纳许多行动,《新一代人工智能展开规划》中也对人工智能的社会危险与道德高度重视。但有必要供认,我国在这方面的研讨仍然是落后的。

现在的人工智能展开,看上去如火如荼,但实际上往哪个方向走才是正确的路途咱们并不确认。是否走了弯路,是否呈现方向过错,决议了一个国家未来的人工智能是不是实在能够展开好。假如做的底子不是人工智能,而是看似智能的大数据剖析、大规模信息处理,那咱们就应该老老实实地和解做这件作业,而不是去假充人工智能,不然的话,会对我国人工智能的科学展开构成本质搅扰和深远影响。

另一件让人忧虑的事,是在2018年9月新加坡政府未来战略研讨中心与剑桥大学合办的人工智能未来论坛上,一位美国投资人做陈述时说,她在乌镇智库的大会上与我国人工智能相关企业负责人沟通时,发现他们简直没有表现出对人工智能危险与道德问题的太多本质的考虑,这让其时大多数与会人员适当吃惊。我当即答复,我国的新一代人工智能展开不或许忍受国家的人工智能渠道对未来社会的影响不做深度战略考虑。

这位投资人说的情况反映出来一个实际问题,便是我国人工智能从业人员在对人工智能潜在的社会危险与道德问题以及对未来管理方面的考虑与世界社会是有间隔的。假如未来咱们在人工智能危险与道德范畴仅仅是跟从研讨,将会十分被迫和费事,由此或许发生的对社会负面影响也将很难估计。

举两个比如来看从技能视点对安全、道德问题进行考虑的必要性。现在深度学习模型在工业界傍边运用得现已十分遍及,但实际是,一张飞机的图片,当其间一个要害像素被改动时,深度学习模型把它辨认成了狗;一张青蛙的图片,当其间一个要害像素被改动时,深度学习模型以为这是一辆货车……试想,当未来大规模的视觉监控体系乃至是机器差人在马路上展开监控使命时,发现一个三岁的小孩手里拿着一只乌龟,这时分有一张白纸片刚好落到适宜的方位上,深度学习体系以为小孩拿着的是一把枪,那时技能决议计划和实在场景之间的差异又会引起什么样的潜在危险?这样一个想象值得咱们去深度考虑现有人工智能模型的安全性和透明性。

有些人以为,有知道的人工智能是一件十分危险的作业,但我的观念是:没有必定程度自我知道的智能模型才是最危险的。

由于具有自我知道的类脑模型具有自我辨认的才能、具有动机与价值观的才能、差异自己和他人的才能、看待他人和看待自己相同的才能,以及与他人共情的才能。机器人假如不能辨认自己、不能为他人建模,那么它为了完结使命就能够献身全部人类的含义,由于它底子不了解人类和它们之间的联系。

德国哲学家托马斯·梅岑格(Thomas Metzinger)说,咱们给机器人植入人工智能道德只要一次时机,假如失利了,那么人类未来就会被推翻了。我的观念是:假如选用植入的手法,则或许一次时机都没有!由于人工智能的模型能够演化,你能够植入,它就能够构建一个接口,使得你植入的部分被围住,未来这个被植入的部分就不能正常作业;而且它能够自组织出一个网络,在输入和输出的层面掩盖全部改变,使得判别模块仍在持续作业,但实际上从全体的模型视点,它现已不再契合人类的规矩了。这便是我以为“一次时机都没有”的原因,这也是为什么我以为一个机器人应该具有推测他人的思想、认知共情乃至情感共情的才能的原因。

每个国家、组织、企业不同的道德规律版别,都是在论述咱们对人工智能道德和原则的知道。包含未来生命研讨所(Future of Life Institute,FLI)阿西洛马会议制定的23条原则,看上去覆盖得比较全面,但仍有许多重要的要素被遗失。对未来超级智能体的规划与危险的点评是这些规律之间差异最显着的点,阿西洛马原则的抢先性也由此闪现。

与之比较,现在我国在人工智能道德方面的研讨存在如下问题:

(1)缺少相对全面和久远的考量,没有对全方位危险的猜测。

(2)我国原则怎样与世界上各版别协同。大多数其他国家在做此类研讨时,参加者至少有一半是人工智能从业人员,可是我国现在绝大多数人工智能道德与管理的研讨参加者没有人工智能的研讨和职业布景。假如呈现这样的景象:提出的道德原则在技能上是不可行的,而道德与管理研讨人员对技能上的潜在危险又不了解,就会对未来社会构成潜在危险与严峻的应战。

未来的人工智能展开,需求有正确的模型,以及在正确模型根底之上展开起来的道德规律。最糟糕的景象是,咱们现在的人工智能,看似是有智能的,但其实它自己也不知道自己在做什么,以及它会带来怎样的危险。固然,就像人工智能体系不能依靠规矩体系去罗列全部的规矩相同,咱们也不或许构建一个极端完善、没有任何缝隙的道德原则。

咱们期望的是,未来的人工智能体系构建于咱们人类的智能之上,它的机制与人类是共同的,它从演化的视点能够呈现更多的利他行为。假如它的模型是从人类根底之上展开起来的,那么它至少现已有了许多的利他行为根底及协同展开的动机。即使也仍是会呈现一些非预期情况,这恐怕也是展开人工智能最安全的途径之一。

读者福利

送书福利!

我国人民大学出版社为全球技能地图的读者供给5本《人工智能全球格式》,参加活动即可取得!

欢迎留言写下你的观念,留言点赞数最高的5位朋友,咱们将送上一本《人工智能全球格式》。

点赞数计算截止时刻:2019年11月10日23:59。

欢迎您的谈论!

研讨所简介

世界技能经济研讨所(IITE)成立于1985年11月,是隶属于国务院展开研讨中心的非营利性研讨组织,首要功能是研讨我国经济、科技社会展开中的严重政策性、战略性、前瞻性问题,盯梢和剖析世界科技、经济展开态势,为中心和有关部委供给决议计划咨询服务。“全球技能地图”为世界技能经济研讨所官方微信账号,致力于向大众传递前沿技能资讯和科技立异洞见。

地址:北京市海淀区小南庄20号楼A座

电话:010-82635522

微信:iite_er

2024华为全屋智能设计大赛·山东站正式启动

2024华为全屋智能设计大赛·山东站正式启动 钱江世纪城“桥上市集”点燃杭城炎炎夏夜

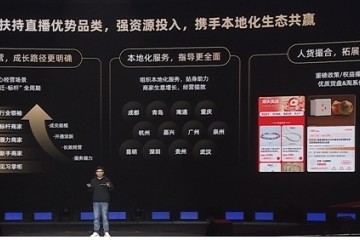

钱江世纪城“桥上市集”点燃杭城炎炎夏夜 走进产业带商家:看淘宝直播如何为商家迎来“新生”

走进产业带商家:看淘宝直播如何为商家迎来“新生” 生鲜业务如何兼顾“高质低价”?揭秘鼻祖级玩家的解题思路

生鲜业务如何兼顾“高质低价”?揭秘鼻祖级玩家的解题思路 “19岁,绝美青春”:绝味鸭脖再推新品引爆中国休闲卤制品市场

“19岁,绝美青春”:绝味鸭脖再推新品引爆中国休闲卤制品市场 淘宝直播产业带新财年服务商大会|百亿流量扶持中小商家续写“源头奇迹

淘宝直播产业带新财年服务商大会|百亿流量扶持中小商家续写“源头奇迹 绝味鸭脖×元梦之星打造数实融合新典范,新品爆一脖39天热卖100万桶

绝味鸭脖×元梦之星打造数实融合新典范,新品爆一脖39天热卖100万桶 膳魔师:以创新之光,照亮百年品牌

膳魔师:以创新之光,照亮百年品牌