2016年初,史蒂芬·霍金进行了两次“里斯演讲”,第一次是关于经典黑洞理论的发展史,第二次是关于量子黑洞理论的发展史,以及最近他在解决黑洞信息丢失问题方面的重大进展。这两次演讲引起了巨大的反响——也难怪,没有什么科学理论,能比“黑洞”更吸引人了。

BBC一年一度的里斯演讲(ReithLectures)设立于1948年,初衷是为了纪念BBC第一任总裁约翰·里斯。里斯演讲的第一位讲者是英国著名哲学家罗素,之后,不同领域的领军任务纷纷出现在里斯演讲的讲堂,并邀请听众共同讨论。演讲的话题非常广泛,涵盖文化、科学、宗教、政治等诸多领域。

“有人说,事实有时比小说更奇妙,没有什么比黑洞的情形更能体现这点了。黑洞比科幻作家的任何异想天开都更怪异,但它们却是已经被科学家证明了的存在。”霍金以此为开篇。两次演讲都只有短短十五分钟,不过里面凝聚了他毕生对于黑洞理论的洞见。

这两次演讲的内容被集结成册,由BBC新闻科学编辑大卫·舒可曼导读,企鹅兰登书屋出版。中译版名为《黑洞不是黑的》。

不论你是打算从零开始了解黑洞,还只是想将你的“黑洞观”刷新到版本,这本体量不大、通俗易懂,却又信息量满满的小册子,都能满足你的需求。

“黑洞并不像想象中的那么黑,如果你觉得自己掉进一个黑洞里,永远不要放弃,总有方法能逃出来!或许是回到我们这个宇宙,或许是逃向另外一个。”

著名的霍金是目前全世界最伟大的人之一,他的言论总是得到世界各地的和认可。早在几年前霍金就曾发表过言论称“人工智能将会是人类灭绝的主要推动力之一”。人工智能的崛起意味着未来机器人的“智慧”将超乎人类,很有可能反抗人类的命令并拥有自己的思想。近日,霍金再发警告,再次提醒世人要特别注意人工智能对未来的威胁。

近几年来,霍金不断发表言论来警醒世人。从一开始的地外生物入侵到某些小行星会撞击地球等等,而他提到次数最多的,也是他自己觉得最有可能的事情就恰恰是工智能的未来人类的危害。对此他表示非常地担忧,但相反,他非常支持人工智能技术,他曾说过人工智能可能是我们文明历史上最为重要的事情之一。

霍金最担心的不是人工智能的开发,而是人工智能会给人类带来的“副作用”。霍金警告说,地球的毁灭正在向我们逼近,人类创造了人工智能,他们可以毁灭我们,但是我们却没有注意到这一点,没有能够建立有效的机制去防止灾难的发生,至今仍然没有机会避免这场灾难。

霍金说:“倘若人类不想走向灭绝,那么我们就要在100年以内离开地球”

2024华为全屋智能设计大赛·山东站正式启动

2024华为全屋智能设计大赛·山东站正式启动 钱江世纪城“桥上市集”点燃杭城炎炎夏夜

钱江世纪城“桥上市集”点燃杭城炎炎夏夜 走进产业带商家:看淘宝直播如何为商家迎来“新生”

走进产业带商家:看淘宝直播如何为商家迎来“新生” 生鲜业务如何兼顾“高质低价”?揭秘鼻祖级玩家的解题思路

生鲜业务如何兼顾“高质低价”?揭秘鼻祖级玩家的解题思路 “19岁,绝美青春”:绝味鸭脖再推新品引爆中国休闲卤制品市场

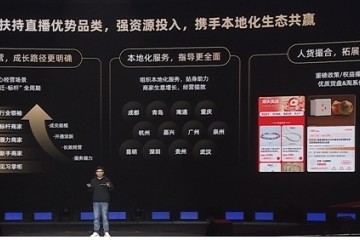

“19岁,绝美青春”:绝味鸭脖再推新品引爆中国休闲卤制品市场 淘宝直播产业带新财年服务商大会|百亿流量扶持中小商家续写“源头奇迹

淘宝直播产业带新财年服务商大会|百亿流量扶持中小商家续写“源头奇迹 绝味鸭脖×元梦之星打造数实融合新典范,新品爆一脖39天热卖100万桶

绝味鸭脖×元梦之星打造数实融合新典范,新品爆一脖39天热卖100万桶 膳魔师:以创新之光,照亮百年品牌

膳魔师:以创新之光,照亮百年品牌